На овом блогу ћемо покрити доле наведени садржај:

- Како прилагодити генерисање текста учитавањем модела са функцијом „цевовод“ из Трансформерса?

- Како користити модел заснован на трансформатору за генерисање текста у ПиТорцх-у?

- Како користити модел заснован на трансформатору за генерисање текста у ТенсорФлов-у?

Како прилагодити генерисање текста учитавањем модела са функцијом „цевовод“ из Трансформерса?

„ цевовод ” функција се користи за аутоматско преузимање унапред обученог АИ модела према захтевима корисника. Да би користили ову одређену функцију, корисници морају да инсталирају „ трансформатори ” пакети. Овај пакет пружа приступ најсавременијим моделима заснованим на трансформаторима који могу да изврше анализу расположења као и више других Обрада природног језика (НЛП) задатака.

Да бисте проверили практичну демонстрацију горе описаног сценарија, пређите на доле наведене кораке!

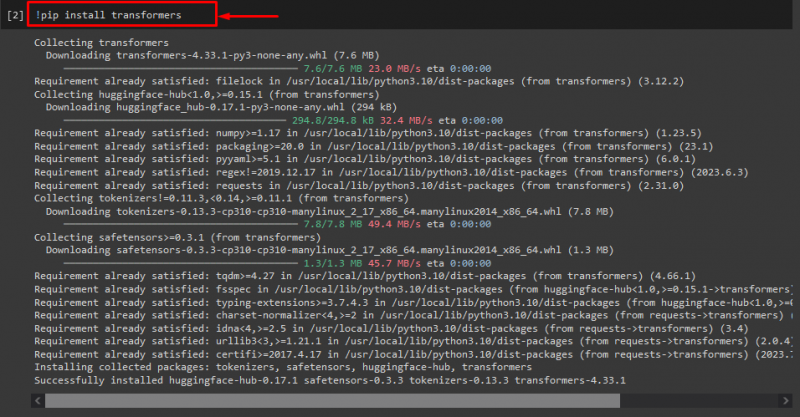

Корак 1: Инсталирајте пакете „трансформатора“.

Прво, извршите „! пип” команда за инсталирање трансформатор пакета:

! пип инсталирати трансформаторе

Као што видите, наведени пакет је успешно инсталиран:

Корак 2: Увезите модел заснован на трансформатору

Затим увезите тражени модел заснован на трансформатору. Да бисте то урадили, прво увезите „ цевовод ” функција из “ трансформатори ”. Затим користите увезену функцију и проследите „ генерисање текста ” као аргумент за то заједно са траженим именом модела “ гпт2 ”. Затим их проследите на „ Генериши ' променљива:

из трансформатори увоз цевовод

Генериши = цевовод ( 'генерисање текста' , модел = 'гпт2' )

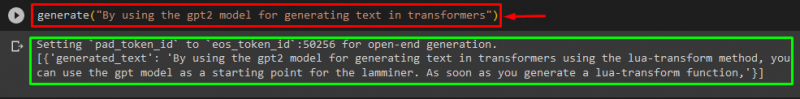

Корак 3: Генеришите прилагођени текст

Сада, проследите жељени текст као аргумент у „ Генериши ”. Како је приказано испод:

Генериши ( „Употребом гпт2 модела за генерисање текста у трансформаторима“ )Према достављеном излазу, преузети претходно обучени “ гпт3 ” модел је успешно генерисан текст:

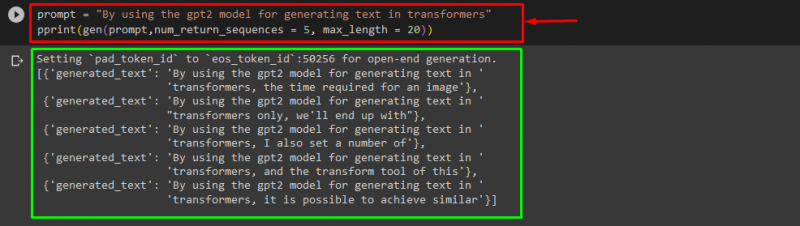

Можете користити и друге аргументе, као што су:

промпт = „Употребом гпт2 модела за генерисање текста у трансформаторима“принт ( ген ( промпт , нум_ретурн_секуенцес = 5 , максимална дужина = двадесет ) )

овде:

- “ промпт ” се користи као аргумент који задржава улаз.

- “ нум_ретурн_секуенце ” аргумент се користи за генерисање броја секвенци датог текста.

- “ максимална дужина ” аргумент се користи за одређивање дужине генерисаног текста. У нашем случају, ограничено је на „ 30 ” токени (речи или интерпункција):

Белешка: Прилагођени текст ће бити наставак наведеног упита који се заснива на подацима о обуци модела.

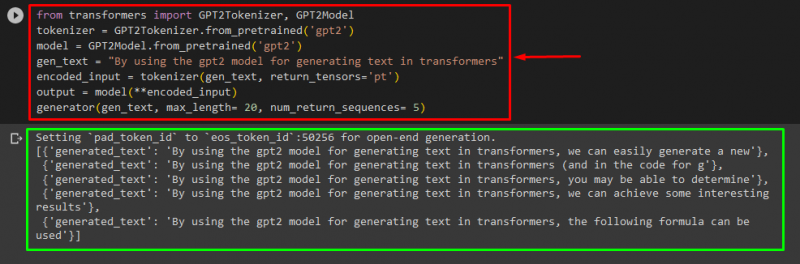

Како користити модел заснован на трансформатору за генерисање текста у ПиТорцх-у?

Корисници такође могу прилагодити текст у „ ПиТорцх ' који је ' Бакља ” заснован оквир за машинско учење. Користи се за различите апликације, као што су НЛП и Цомпутер Висион. Да бисте користили модел заснован на трансформатору за прилагођавање текста у ПиТорцх-у, прво увезите „ ГПТ2Токенизер ' и ' ГПТ2Модел ” функције из „ трансформатори ”:

из трансформатори увоз ГПТ2Токенизер , ГПТ2МоделЗатим користите „ ГПТ2Токенизер ” токенизер према нашем жељеном унапред обученом моделу под називом “ гпт2 ”:

токенизер = ГПТ2Токенизер. фром_претраинед ( 'гпт2' )Након тога, инстанцирање тежине из претходно обученог модела:

модел = ГПТ2Модел. фром_претраинед ( 'гпт2' )Затим, прогласите „ ген_тект ” променљива која садржи текст који желимо да прилагодимо:

ген_тект = „Употребом гпт2 модела за генерисање текста у трансформаторима“Сада, проследите „ ген_тект ' и ' ретурн_тенсорс=‘пт’ ” као аргумент који ће генерисати текст у ПиТорцх-у и сачувати генерисану вредност у „ енцодед_инпут ' променљива:

енцодед_инпут = токенизер ( ген_тект , ретурн_тенсорс = 'пт' )На крају, проследите „ енцодед_инпут ” променљива која држи прилагођени текст у „ модел ” као параметар и добијете резултујући излаз користећи „ максимална дужина ” аргумент који је подешен на „ двадесет ” што указује да ће генерисани текст бити ограничен на дате токене, „ нум_ретурн_секуенцес “ који је постављен на “ 5 ” што показује да ће се генерисани текст ослањати на 5 секвенци текста:

излаз = модел ( **енцодед_инпут )генератор ( ген_тект , максимална дужина = двадесет , нум_ретурн_секуенцес = 5 )

Излаз

Како користити модел заснован на трансформатору за генерисање текста у ТенсорФлов-у?

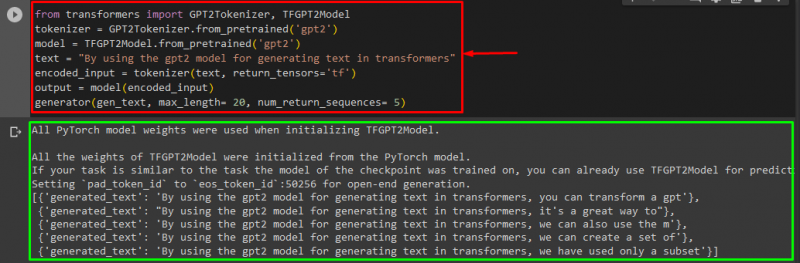

За генерисање текста у Трансформерсима, „ ТенсорФлов ” се такође користе оквири за машинско учење. Да бисте то урадили, прво увезите потребне функције, као што је „ ГПТ2Токенизер ' и ' ТФГПТ2Модел ' од ' трансформатори ”. Остатак кода је исти као горе, само користимо „ ТФГПТ2Модел ” функција уместо “ ГПТ2Модел ” функција. Као што следи:

из трансформатори увоз ГПТ2Токенизер , ТФГПТ2Моделтокенизер = ГПТ2Токенизер. фром_претраинед ( 'гпт2' )

модел = ТФГПТ2Модел. фром_претраинед ( 'гпт2' )

текст = „Употребом гпт2 модела за генерисање текста у трансформаторима“

енцодед_инпут = токенизер ( текст , ретурн_тенсорс = 'тф' )

излаз = модел ( енцодед_инпут )

генератор ( ген_тект , максимална дужина = двадесет , нум_ретурн_секуенцес = 5 )

Као што видите, прилагођени текст је успешно генерисан:

То је то! Разрадили смо прилагођавање генерисања текста у Трансформерсима.

Закључак

Да бисте прилагодили генерисање текста у Трансформерс-у, постоје различити начини као што је учитавање модела са функцијом цевовода, коришћењем модела заснованог на трансформатору у „ ПиТорцх ' и ' ТенсорФлов ” који су засновани на оквирима машинског учења. У овом водичу дали смо кратке информације заједно са практичном демонстрацијом прилагођавања генерисања текста у Трансформерс-у.