Синтакса:

Различите функције потпадају под Обраду природног језика за уграђивање речи у текст. Овај чланак покрива функцију „ворд2вец“ за ову сврху. Да би било јасније, реч ембеддинг конвертује наше уносе текста у векторску репрезентацију где оне речи које имају мање-више иста контекстуална значења дају исту репрезентацију.

Алгоритам „ворд2вец“ је модел неуронске мреже који је обучен на такав начин да учи уградњу речи тако што прво предвиђа контекст речи у којем се појављује. Овај модел узима текст као свој улаз. Затим се за сваку реч у тексту креира векторски приказ за ту реч. Овај модел се заснива на идеји да речи за које се чини да имају исти контекст имају исто значење. Синтакса за „ворд2вец“ је следећа:

$ Ворд2Вец(реченице, мин_број)

Овај алгоритам има два параметра који су „реченице“ и „минимални_број“. Реченица је променљива у којој се чува листа реченица или текст у облику реченица, а минимум_цоунт говори о вредности броја 1 што значи да било коју реч у тексту која се појавила мање од једне треба занемарити .

Пример 1:

У овом примеру креирамо уграђивање речи за речи које постоје на листи енглеских реченица. Да бисмо креирали реч „ембеддинг“, потребно је да користимо модел „ворд2вец“. Овај модел је пакет Пајтонове библиотеке „генсим“. Морамо да имамо инсталиран Генсим у нашим репозиторијумима Питхон библиотеке да бисмо радили са „ворд2вец“.

Да бисмо применили овај пример, радићемо на „гоогле цолаб“ онлајн Питхон компајлеру. Да бисте инсталирали генсим, користите команду „пип инсталл генсим“. Ово почиње преузимање ове библиотеке са свим повезаним пакетима. Једном када је инсталиран, увезите пакет „ворд2вецтор“ из генсим-а.

Да бисмо обучили овај модел „ворд2вец“, морамо да креирамо скуп података за обуку. За то креирамо листу реченица која садржи четири до пет енглеских реченица. Ову листу чувамо у променљивој „траининг_дата“.

Наш следећи корак након креирања скупа података за обуку је да обучимо модел „ворд2вец“ на овим подацима. Дакле, зовемо модел. Податке о обуци дајемо у улазним параметрима овог модела које смо сачували у променљивој „улаз“. Затим наводимо други параметар који је „минимум_цоунт“. Поставили смо његову вредност једнаку '1'. Излаз из овог модела обуке се чува у променљивој “траинед_модел”.

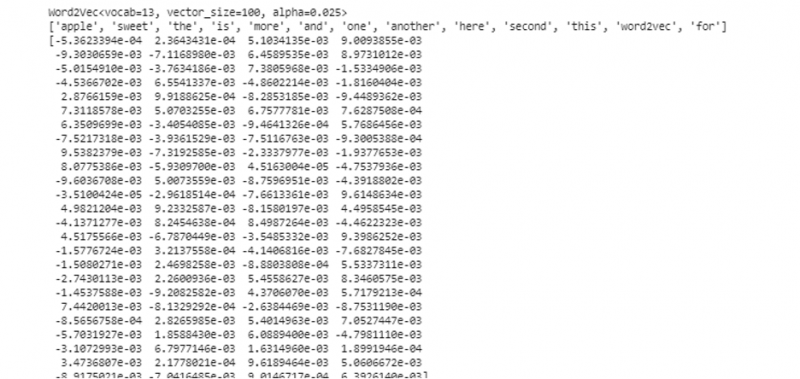

Када завршимо са обучавањем модела, можемо једноставно приступити моделу са „вв“ префиксом који је реч векторски модел. Такође можемо приступити речнику токена наших речи и можемо их одштампати на следећи начин:

воцабоф_токенс = листа (модел.вв.воцаб)Модел представља обучени модел у нашем случају. Сада приступамо векторском представљању једне речи на листи реченице која је, у нашем случају, „јабука“. То радимо једноставним позивањем обученог модела. Реч чију векторску представу желимо да одштампамо прослеђујемо као „модел. вв [‘јабука’]” свом улазном аргументу. Затим штампамо резултате помоћу функције „штампање“.

из као нација модели увоз Ворд2Вецподаци о обуци = [ [ 'јабука' , 'је' , 'тхе' , 'слатко' , 'јабука' , 'за' , 'ворд2вец' ] ,

[ 'ово' , 'је' , 'тхе' , 'други' , 'јабука' ] ,

[ 'овде' , 'други' , 'јабука' ] ,

[ 'један' , 'слатко' , 'јабука' ] ,

[ 'и' , 'више' , 'слатко' , 'јабука' ] ]

модел = Ворд2Вец ( подаци о обуци , мин_цоунт = 1 )

принт ( модел )

воцабоф_токенс = листа ( модел. вв . индек_то_кеи )

принт ( воцабоф_токенс )

принт ( модел. вв [ 'јабука' ] )

Из претходно поменутог излаза и кода, приказано је уграђивање речи за реч „јабука“. У примеру, прво смо креирали скуп података за обуку. Затим смо обучили модел на њему и сумирали модел. Затим, користећи модел, добили смо приступ речнику речи. Након тога, приказали смо уграђивање речи за реч „јабука“.

Пример 2:

Користећи генсим библиотеку, направимо још једну листу реченица. Обучите наш модел за сваку реч у реченици да бисте креирали уградњу речи користећи модел „ворд2вец“. Прво, из пакета библиотеке генсим, увози се модел „ворд2вец“. Затим креирамо други скуп података који ће бити листа која има две реченице. Свака реченица на листи има четири речи.

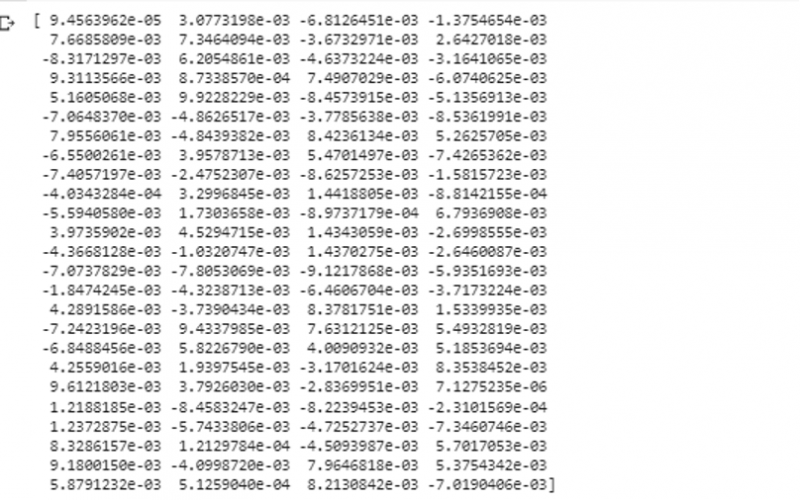

Сада, ову листу чувамо у променљивој „подаци“. Затим, позивамо модел „ворд2вец()“ и уносимо податке у аргументе овог модела са минималном вредношћу_цоунт која је једнака „1“. Овако тренирамо наш модел. Сада је у стању и може да научи да уграђује речи које постоје у реченицама које су присутне на листи предвиђајући контекст у којем оне постоје. Да бисмо тестирали резултате нашег модела, једноставно проследимо реч као што је „пас“ у нашим подацима у модел. Затим штампамо резултате помоћу функције „принт()“.

из као нација модели увоз Ворд2Вецподатака = [ [ 'зец' , 'има' , 'зуби' ] , [ 'пас' , 'има' , 'уши' ] ]

модел = Ворд2Вец ( података , мин_цоунт = 1 )

принт ( модел. вв [ 'пас' ] )

Можемо посматрати векторску репрезентацију речи коју смо унели у модел као њен улаз из претходног исечка излаза.

Закључак

Овај водич демонстрира метод за креирање уграђивања речи за речи које постоје на листи енглеских реченица. Сазнали смо за Питхон библиотеку „генсим“ која обезбеђује модел „ворд2вец“ за креирање уграђивања речи. Штавише, научили смо о улазним параметрима, како да тренирамо модел „ворд2вец“ на подацима обуке и како да представимо реч у репрезентацији вектора.